...

2025年02月13日 07:31 广东

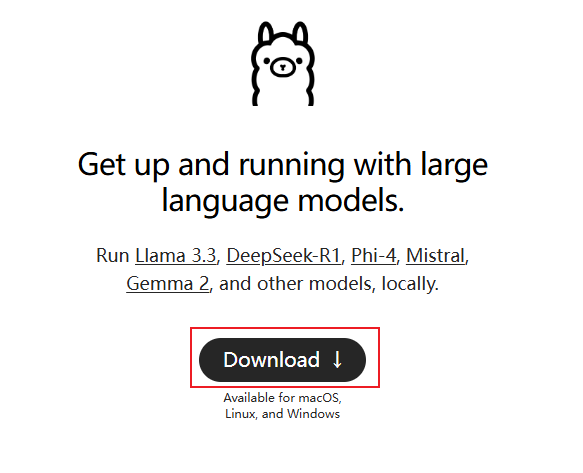

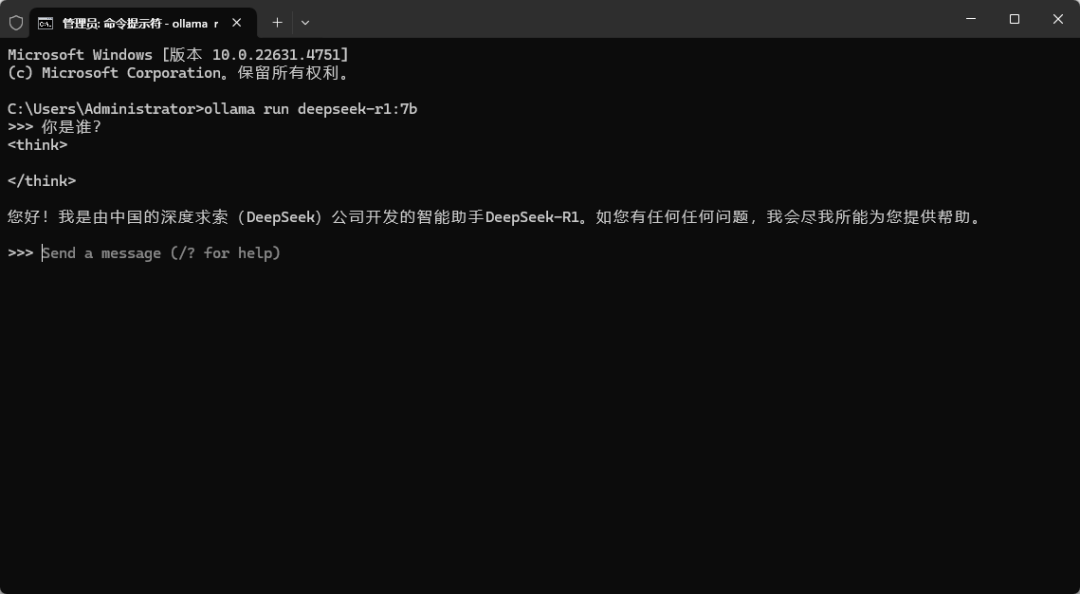

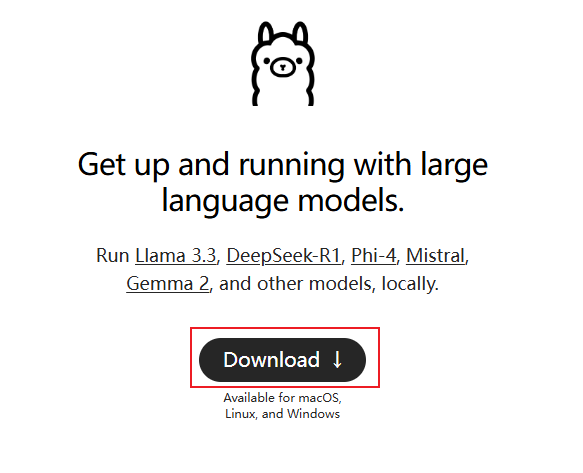

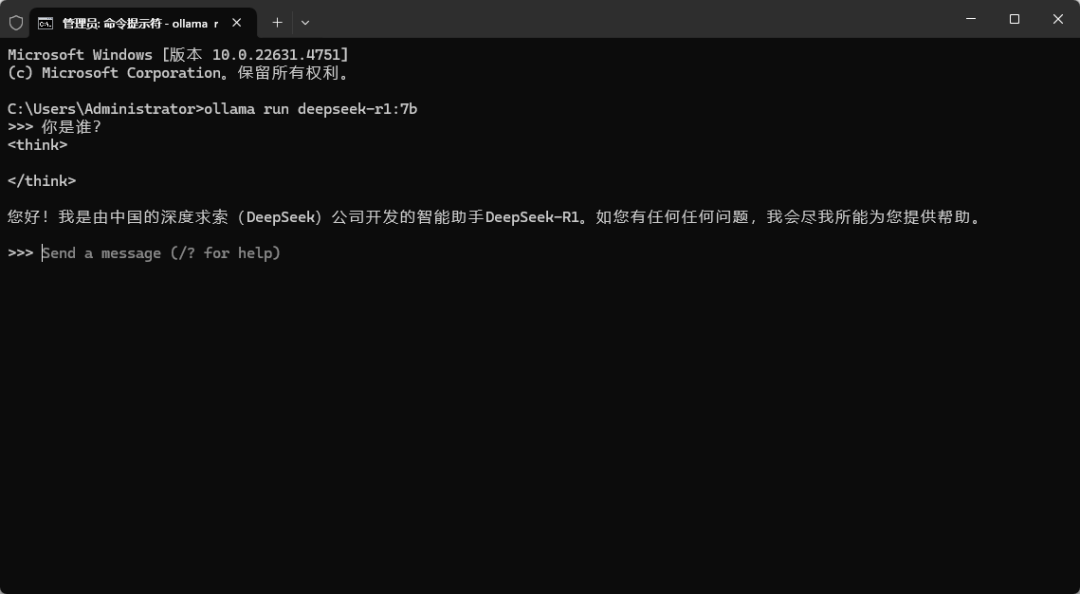

前些天,零零散散更新了几篇本地部署DeepSeek的教程,搭建个人知识库,相信都得到深刻了解。详见: 看了下评论区,大概有这几种问题:Docker的安装挡住了90%的人,本地部署不能联网搜索等等。 今天就来解决这些问题,一个本地部署+私人知识库+联网搜索的终极方案。 如果你是老粉,看过我以前的文章,这一步可跳过,直接ollama run deepseek-r1:1.5b。 首先打开ollama官网:https://ollama.com CMD命令窗口运行,启动deepseek-r1模型:

ollama run deepseek-r1:7b

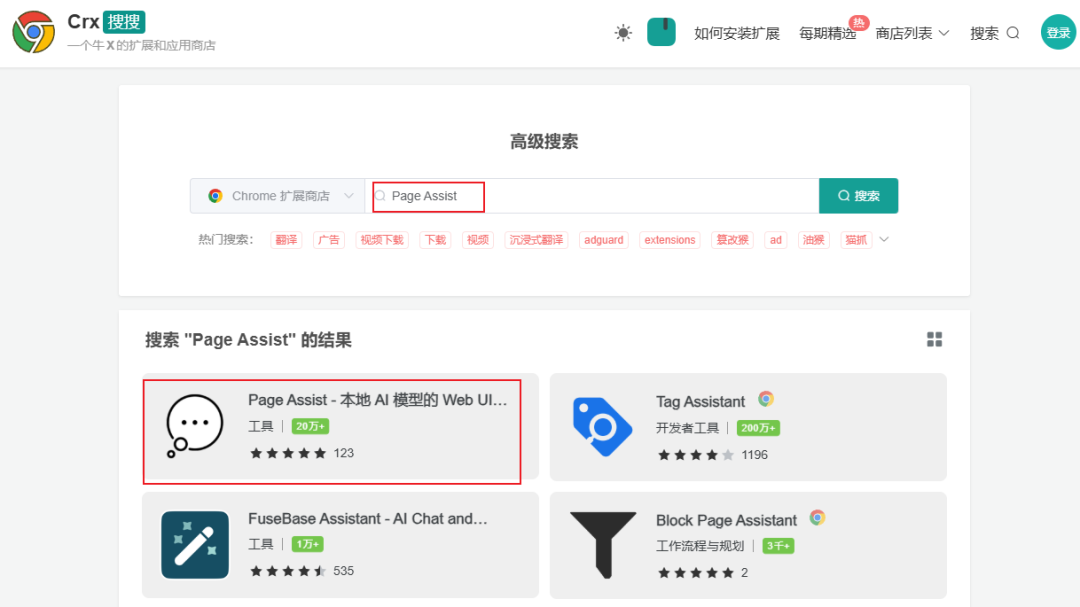

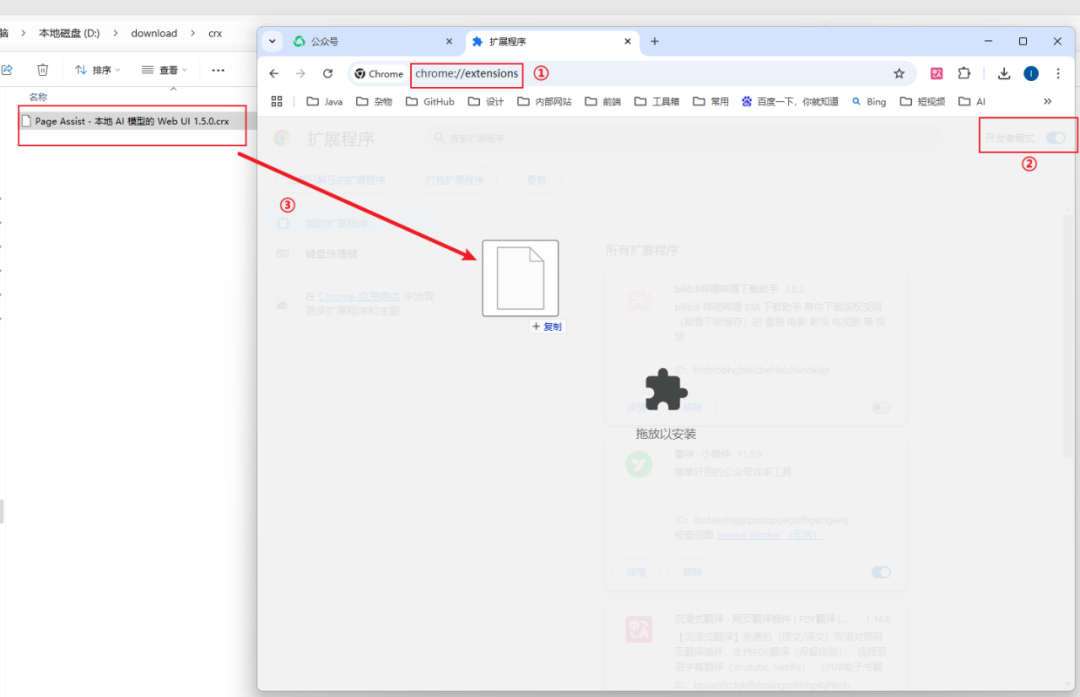

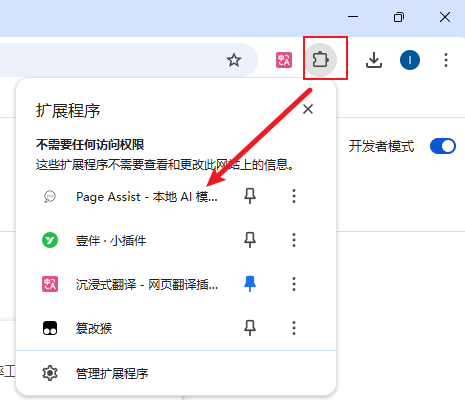

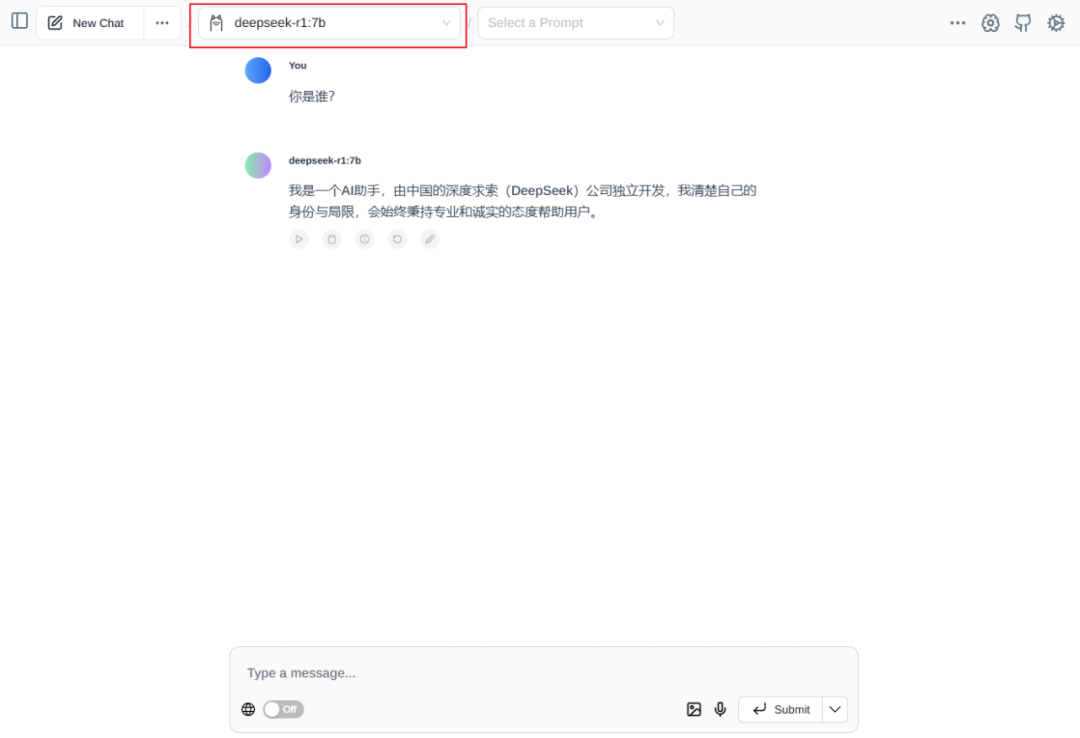

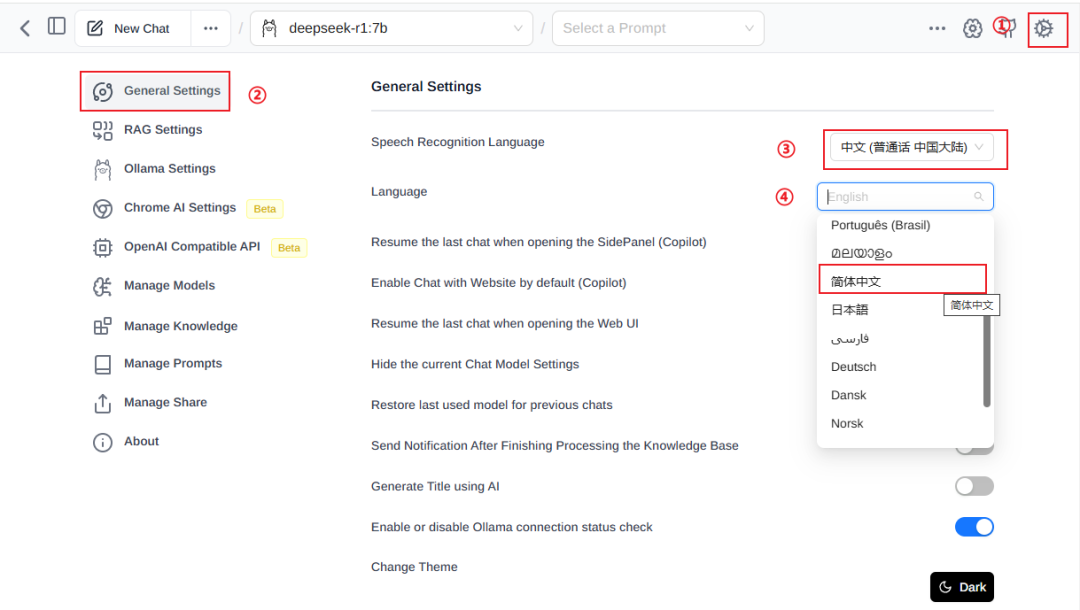

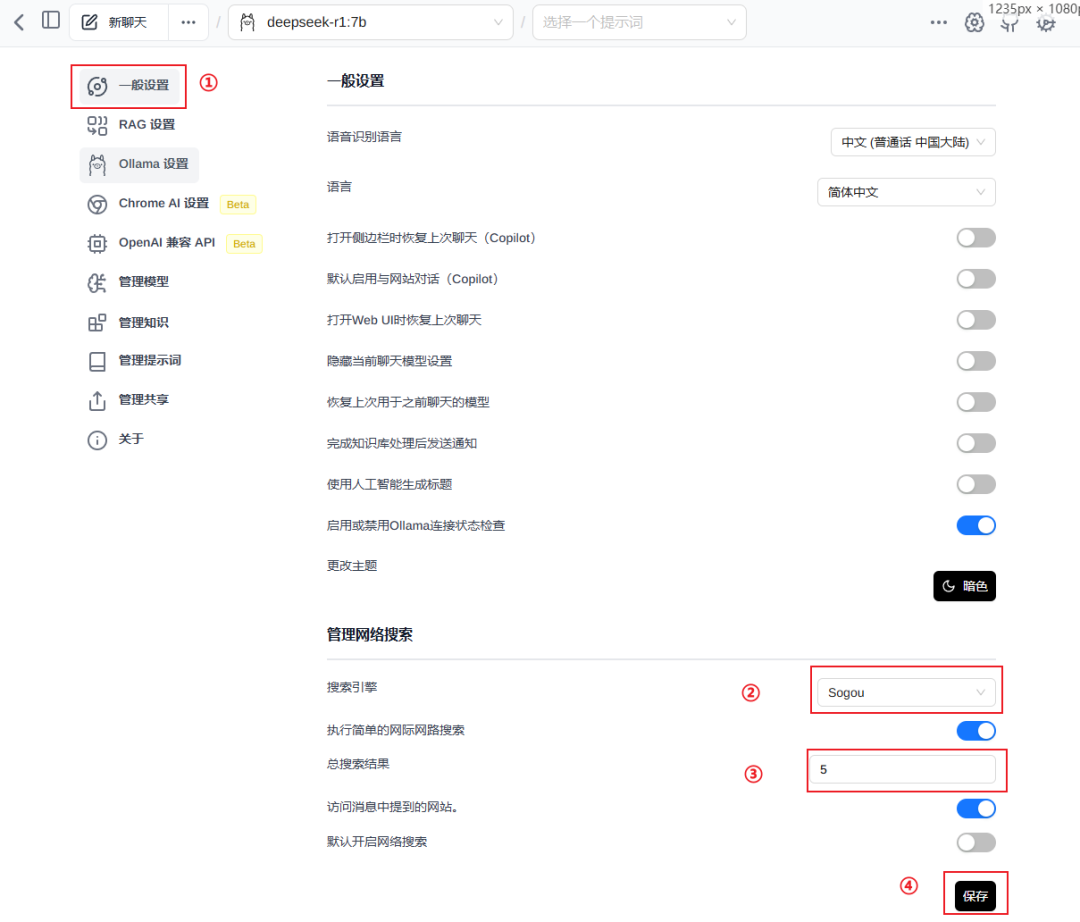

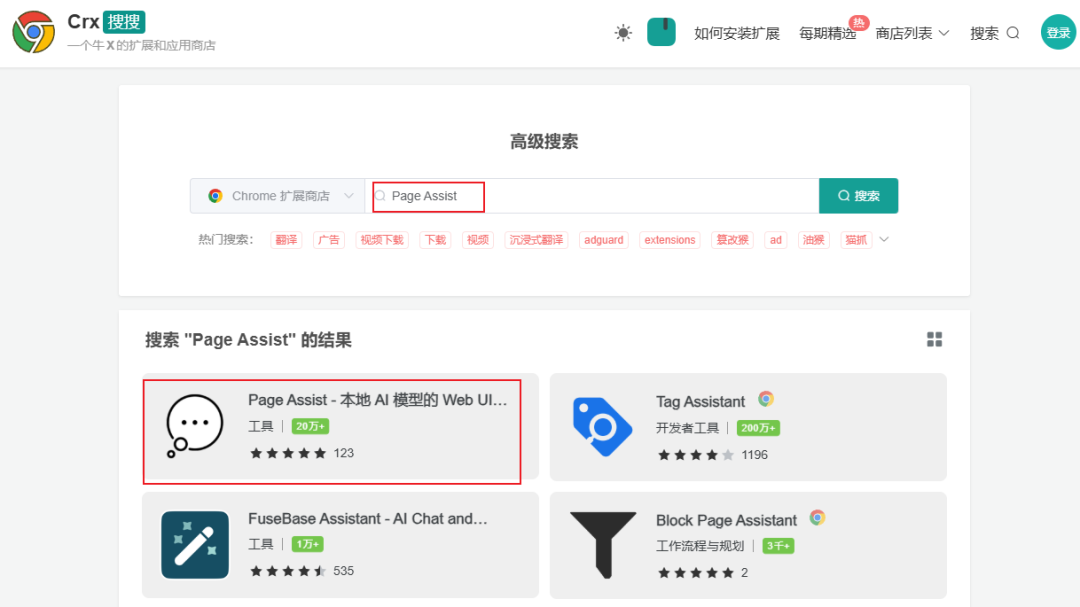

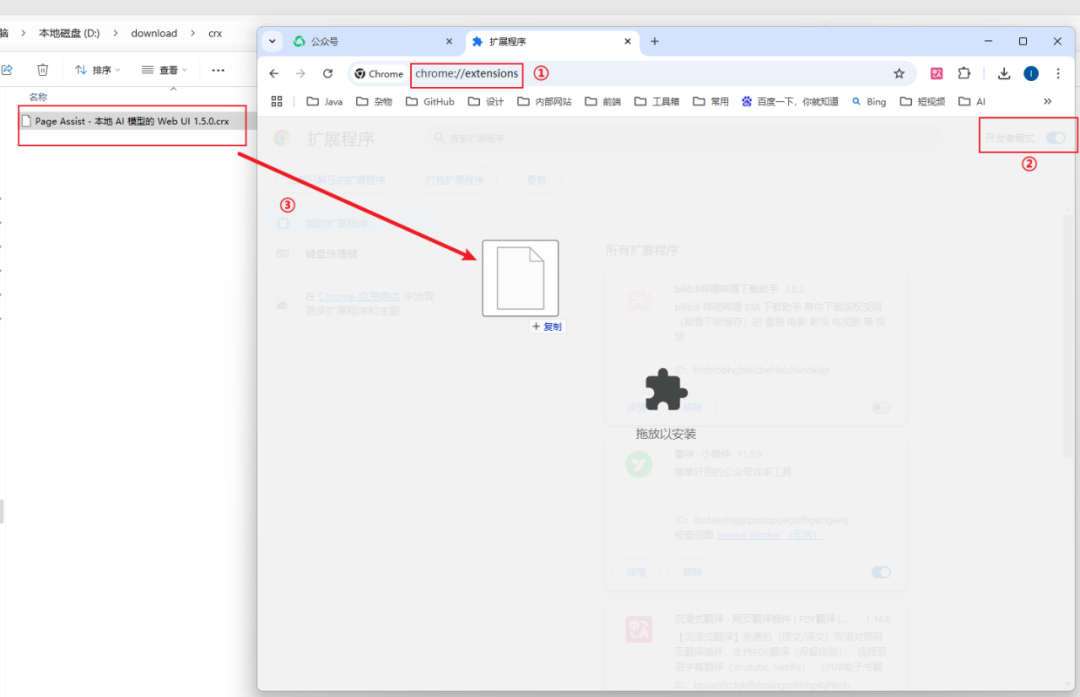

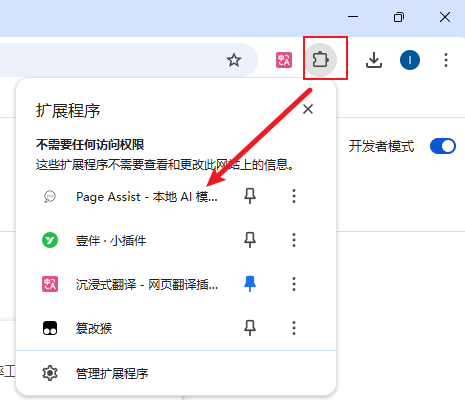

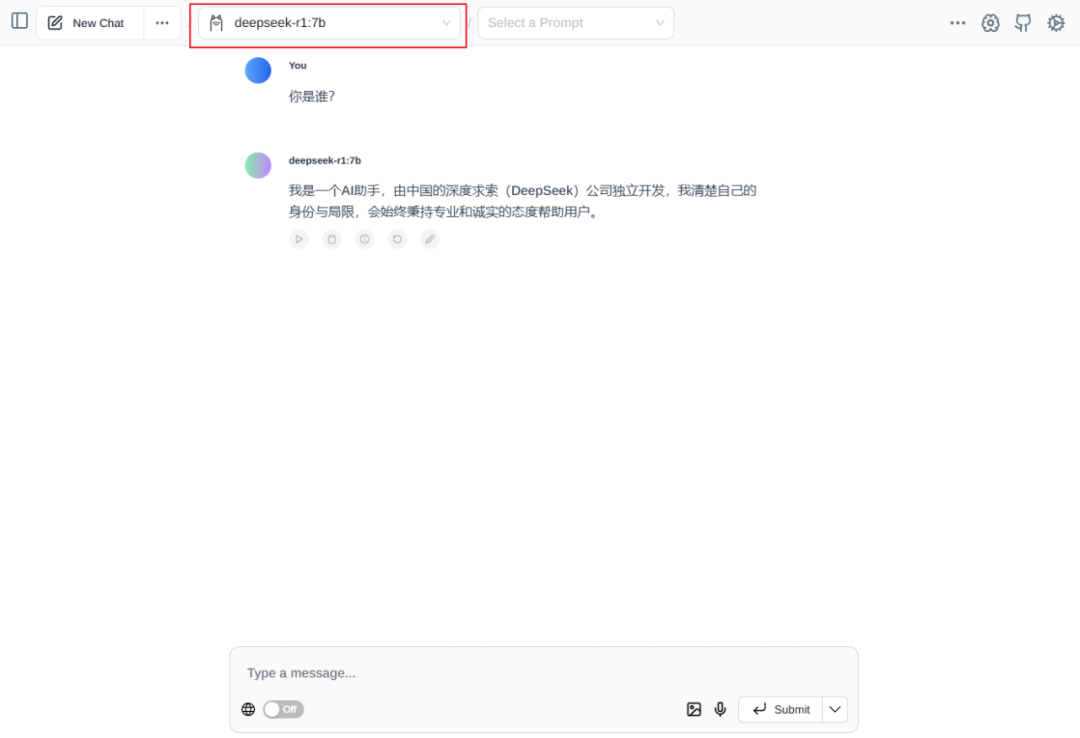

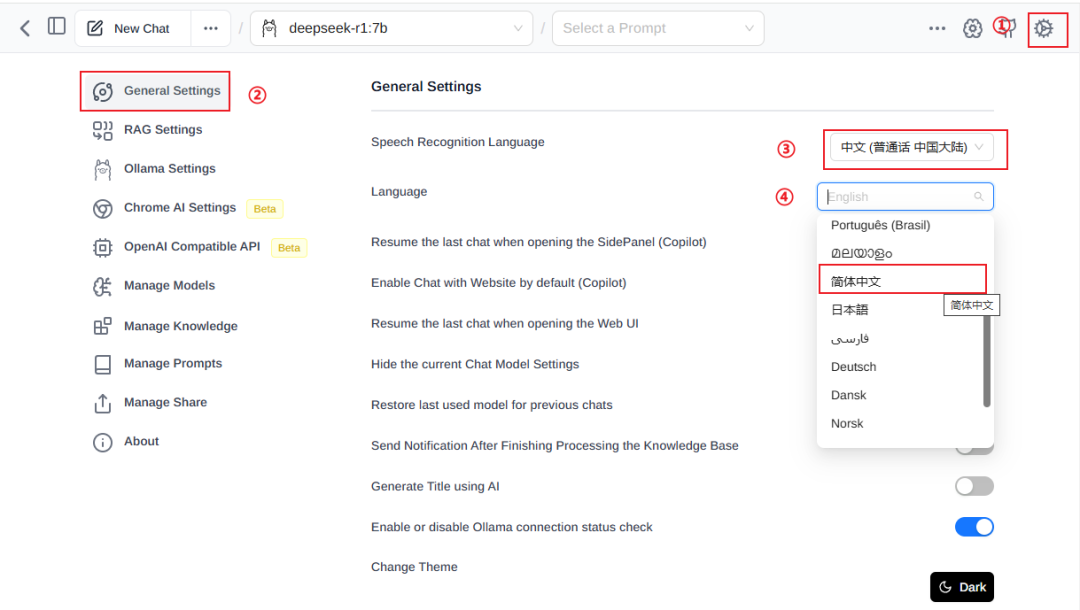

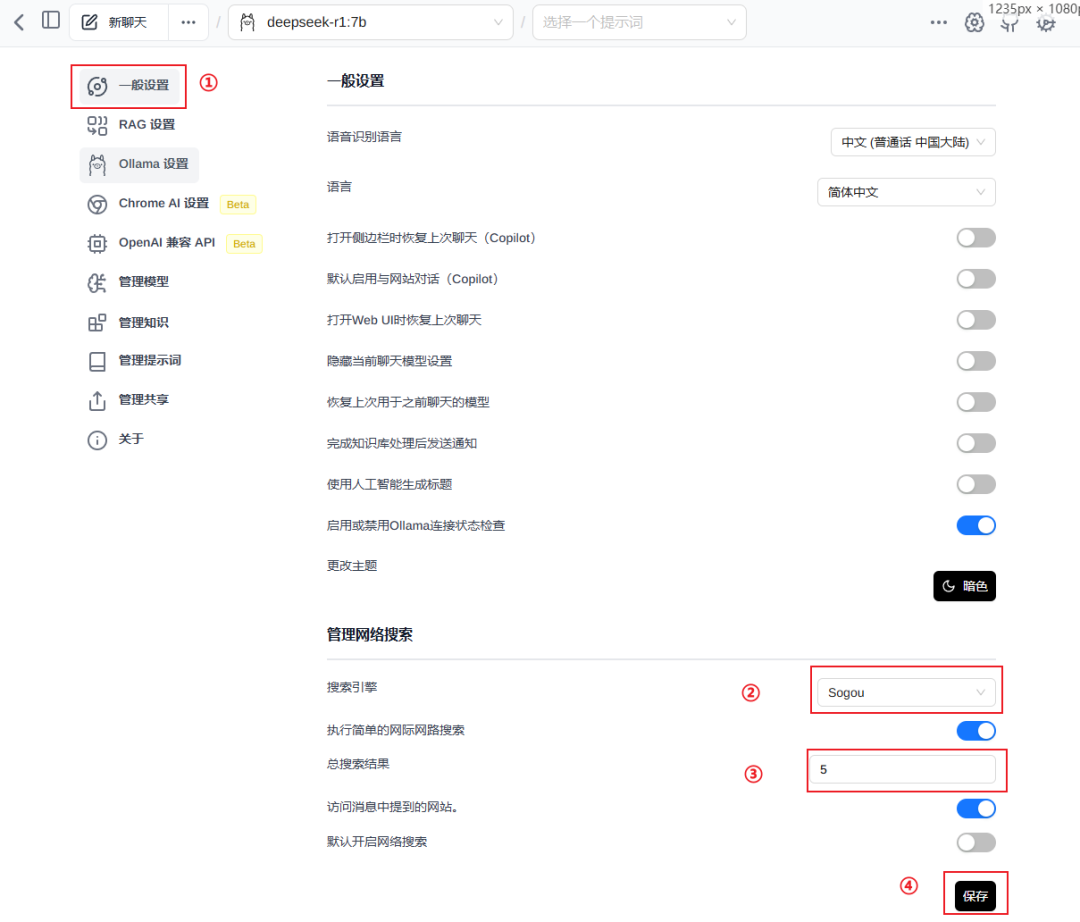

根据自己显卡大小,选择对应的参数规模,1.5b最小,可以先用这个来尝试,完成以后再跑更大的参数模型。 另外有人反馈,任务管理器显示,大模型在执行的时候,回答很慢,GPU几乎没动,全都是CPU 跑。 大概率是安装了老版本的Ollama,官网下载最新的文件重新安装即可。 网络条件允许的话,直接谷歌商店搜索下载,下面介绍的方法国内网络可用。 搜索:Page Assist,第一个就是今天主角,本地AI模型的Web UI。 下载到本地,谷歌浏览器打开:chrome://extensions/,右上角打开开发者模式,将下载好的crx文件拖入浏览器,完成插件的安装。 浏览器上方的扩展程序列表,找到Page Assist插件,点击进入WebUI界面。 左上角可以选择ollama的所有本地模型,所以选deepseek-r1:7b就好了。 到这一步就可以流畅地使用deepseek大模型啦。 首次使用是英文版,不太习惯,点击右上角设置齿轮,【General Settings】,分别选择【简体中文】。 依然是右上角设置齿轮,【一般设置】,下方有个【管理网络搜索】,选择合适的搜索引擎,总搜索结果默认是2,可以适当调大一些,这样参考网络资源的权重更大。 回到聊天页面,打开聊天框下方的【搜索互联网】开关,联网搜索功能就搞定啦。 比如问一个关于《哪吒2》的评价,除了看到思考过程,下方还有列出了引用的数据来源。 CMD窗口运行命令:

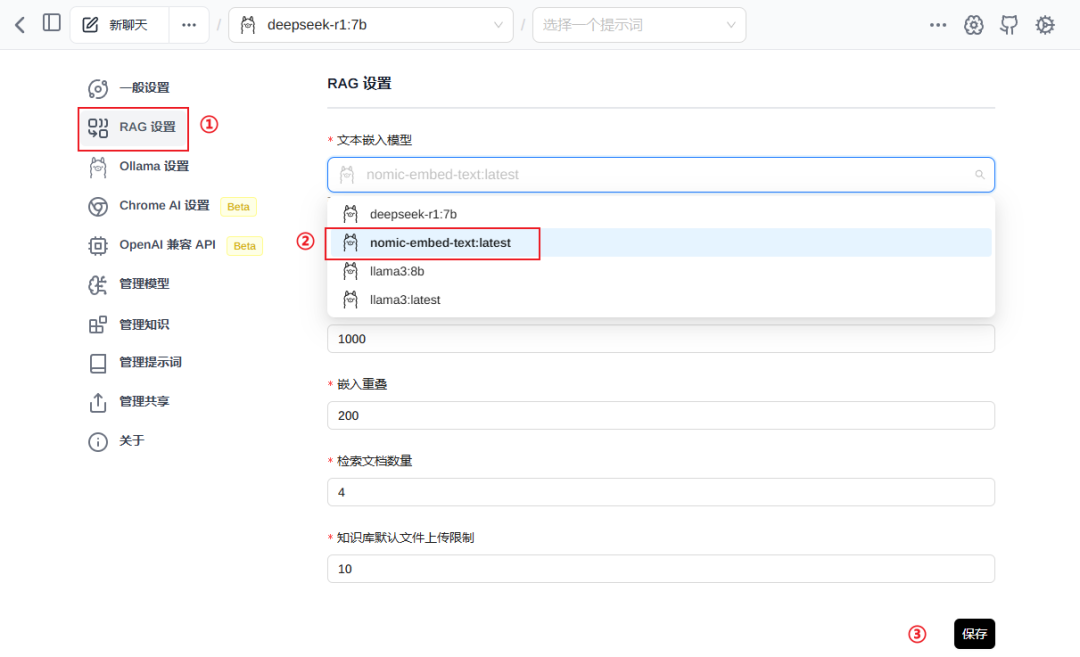

ollama pull nomic-embed-text

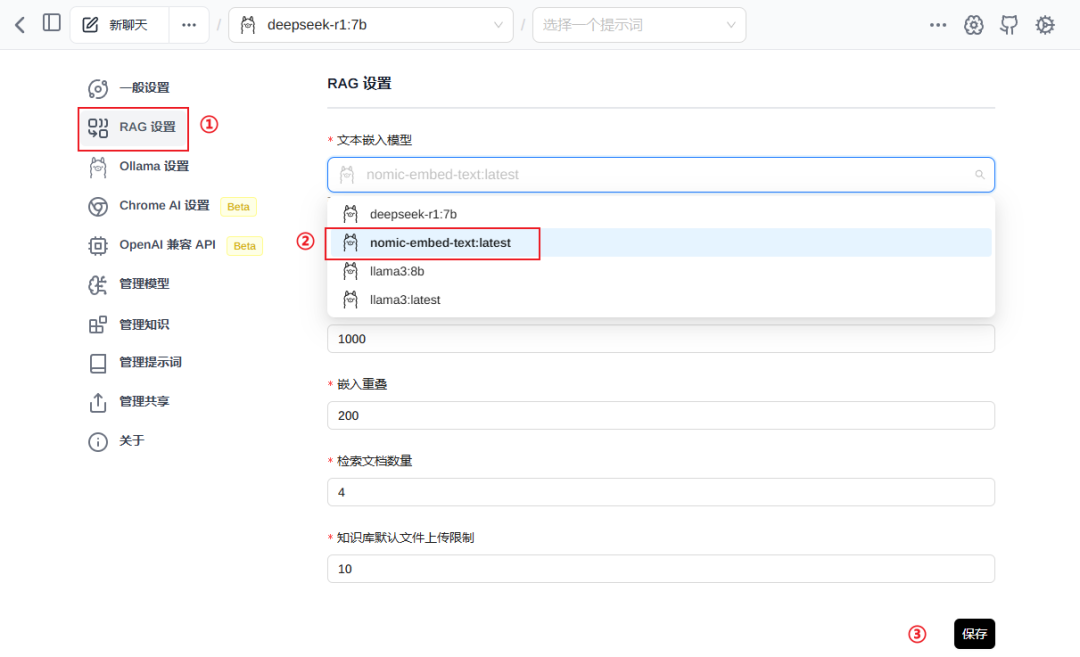

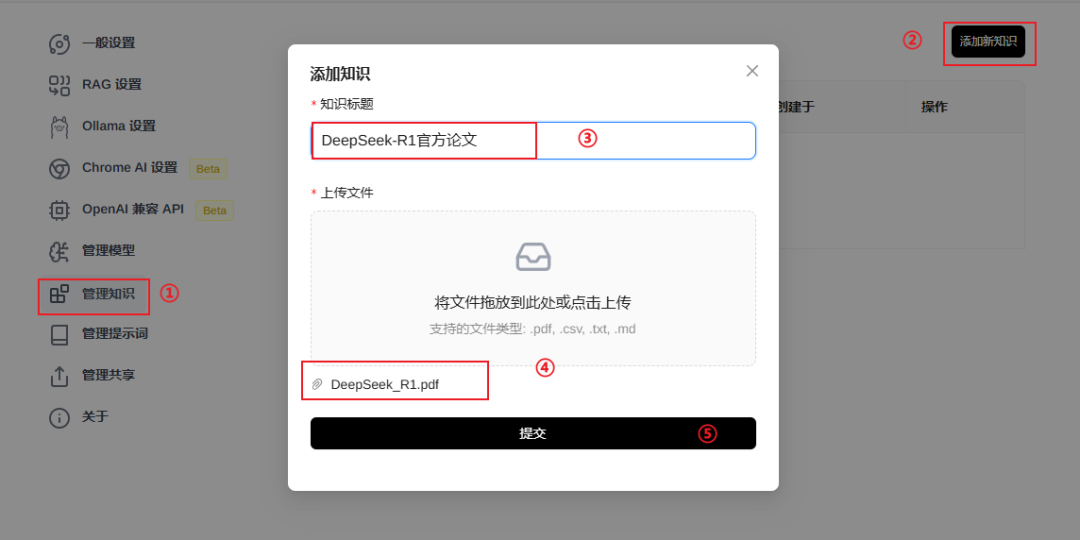

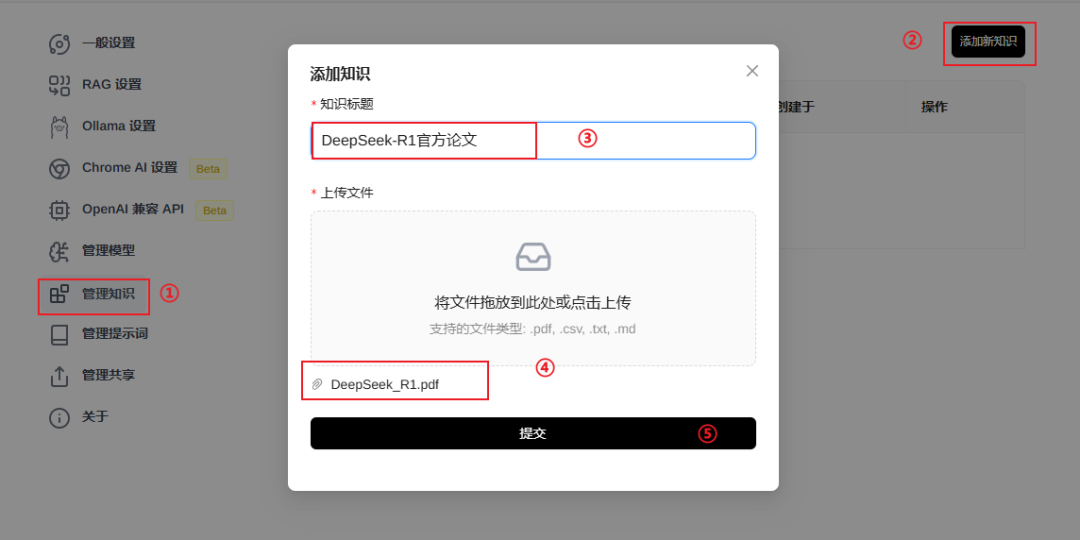

回到设置,【RAG设置】,文本嵌入模型选择【nomic-embed-text:latest】,保存。 文本嵌入模型的作用是,让大模型理解我们的文本资料。 左侧菜单【管理知识】,【添加新知识】,指定知识的标题,并上传我们的本地资料,提交。 这里的知识,指的就是知识库,当状态是【已完成】,代表大模型已经处理完成了。 提问:

DeepSeek-R1是什么?

本地大模型完美地回答了我们的问题,知识库搭建完成! 简单回顾一下,这次的方案:Ollama + Page Assist插件,没有docker的复杂配置,而且完美地实现了本地部署+联网搜索+知识库。 最后,送一波福利,我的一个免费星球,上面整理了各种学习DeepSeek的资料: 1.清华大学课程第一讲《DeepSeek从入门到精通》 2.清华大学课程第二讲《DeepSeek如何赋能职场应用?》 3.全网各种DeepSeek学习资料,持续更新...

觉得文章有用就打赏一下文章作者

支付宝扫一扫打赏 微信扫一扫打赏

上一篇用本地文件调教 DeepSeek-机器学习与数学 下一篇3 个令人惊艳的 DeepSeek 项目,诞生了!-GitHubDaily

用本地文件调教 DeepSeek-机器学习与数学 上一篇

3 个令人惊艳的 DeepSeek 项目,诞生了!-GitHubDaily 下一篇

还没有评论,来说两句吧...